Cyberangriffe treffen alle 39 Sekunden ein Unternehmen weltweit. Ransomware-Attacken kosten deutsche Unternehmen durchschnittlich 2,4 Millionen Euro pro Vorfall. Gleichzeitig verschärft die DSGVO die rechtlichen Anforderungen an den Datenschutz erheblich.

Dieser Leitfaden zeigt Ihnen, wie Sie eine robuste Datensicherheitsarchitektur aufbauen, die sowohl technische als auch rechtliche Herausforderungen meistert.

Die 5 Säulen moderner Datensicherheit

🔒 Backup-Strategien

📋 DSGVO-Compliance

☁️ Cloud-Sicherheit

🛡️ Zero-Trust-Architektur

🚨 Disaster Recovery

Was Sie in diesem Leitfaden lernen

✅ Praxiserprobte Backup-Strategien für verschiedene Unternehmensgrößen

✅ DSGVO-konforme Datenschutzmaßnahmen mit Checklisten

✅ Cloud-Sicherheitskonzepte für AWS, Azure und Google Cloud

✅ Zero-Trust-Implementierung Schritt für Schritt

✅ Disaster Recovery Pläne mit Notfallszenarien

1. Warum Datensicherung und Datensicherheit entscheidend für Ihren Erfolg sind

In der digitalen Wirtschaft sind Daten der Motor für Wachstum und Effizienz. Ob Kundendaten, Geschäftsprozesse oder innovative Ideen – ihr Schutz ist keine Option, sondern eine strategische Notwendigkeit.

Ein effektives Konzept für Datensicherung und Datensicherheit ist das Fundament, das Ihr Unternehmen vor existenzbedrohenden Risiken schützt und das Vertrauen Ihrer Kunden sichert.

1.1 Die realen Bedrohungen für Ihre Daten

Die Gefahren sind vielfältig und entwickeln sich ständig weiter. Es geht längst nicht mehr nur um defekte Festplatten. Die größten Risiken für Unternehmen heute sind:

⭕ Cyberangriffe

Ransomware kann Ihr gesamtes Netzwerk verschlüsseln und lahmlegen. Gezielte Angriffe zielen darauf ab, Geschäftsgeheimnisse zu stehlen. Laut aktuellen Studien erleiden 37% der Unternehmen mindestens einen Ransomware-Angriff pro Jahr.

⭕ Datenlecks

Ob durch menschliches Versagen oder Sicherheitslücken – der Verlust sensibler Kunden- oder Unternehmensdaten schädigt Ihre Reputation nachhaltig. 95% aller Datenschutzverletzungen sind auf menschliche Fehler zurückzuführen.

⭕ Gesetzliche Risiken

Die Nichteinhaltung von Vorgaben wie der DSGVO (Datenschutz-Grundverordnung) kann zu empfindlichen Bußgeldern und rechtlichen Konsequenzen führen. Strafen erreichen bis zu 4% des weltweiten Jahresumsatzes.

⭕ Technisches Versagen & höhere Gewalt

Systemausfälle, Softwarefehler oder Naturkatastrophen können Daten unwiederbringlich zerstören, wenn keine Sicherung existiert. Hardware-Ausfälle betreffen jährlich 6% aller Unternehmen.

1.2 Datensicherung vs. Datensicherheit 🠒 Zwei Seiten einer Medaille

Obwohl die Begriffe oft synonym verwendet werden, erfüllen sie unterschiedliche, aber sich ergänzende Aufgaben. Das Verständnis dieses Unterschieds ist der erste Schritt zu einer lückenlosen Schutzstrategie.

Datensicherung (Backup) stellt sicher, dass Ihre Daten nach einem Verlust (z. B. durch einen Angriff oder Defekt) wiederherstellbar sind. Das Ziel ist die Datenverfügbarkeit.

Beispiel: Ein tägliches Backup aller wichtigen Firmendaten auf einem externen Server mit automatischer Versionierung und Prüfsummen-Validierung.

Datensicherheit (Security) schützt Ihre Daten proaktiv vor unbefugtem Zugriff, Diebstahl oder Manipulation. Das Ziel ist Datenintegrität und Vertraulichkeit.

Beispiel: Eine Next-Generation-Firewall, die den Zugriff auf Ihr Netzwerk kontrolliert, oder die End-to-End-Verschlüsselung sensibler Dateien mit AES-256-Standard.

📊 Vergleich: Datensicherung vs. Datensicherheit

| Aspekt | Datensicherung (Backup) | Datensicherheit (Security) |

| Ziel | Datenwiederherstellung nach Verlust | Schutz vor unbefugtem Zugriff |

| Fokus | Reaktiv (nach einem Vorfall) | Proaktiv (vor einem Vorfall) |

| Kernfrage | „Wie schnell können wir unsere Daten wiederherstellen?“ | „Wer darf auf welche Daten zugreifen?“ |

| Methoden | Backups, Replikation, Snapshots | Verschlüsselung, Firewalls, Zugriffskontrollen |

| Messgrößen | RTO (Recovery Time Objective), RPO (Recovery Point Objective) | Bedrohungserkennungsrate, Zugriffszeiten |

1.3 Was Sie in diesem Leitfaden erwartet

Dieser Leitfaden ist Ihr praktischer Begleiter durch die zentralen Säulen einer modernen Datenstrategie. Wir decken die folgenden Kernbereiche ab:

🔒 Effektive Backup-Strategien

Von der bewährten 3-2-1-Regel bis zur Auswahl der richtigen Backup-Art. Lernen Sie, wie Sie Recovery Time Objectives (RTO) und Recovery Point Objectives (RPO) optimal definieren.

☁️ Grundlagen der Cloud-Sicherheit

Verstehen Sie das Shared-Responsibility-Modell und sichern Sie Ihre Cloud-Umgebung ab. Wir behandeln AWS, Azure und Google Cloud spezifische Sicherheitsmaßnahmen.

📋 DSGVO-Compliance in der Praxis

Setzen Sie technische und organisatorische Maßnahmen (TOMs) korrekt um. Inklusive Checklisten für Datenschutz-Folgenabschätzungen und Privacy by Design.

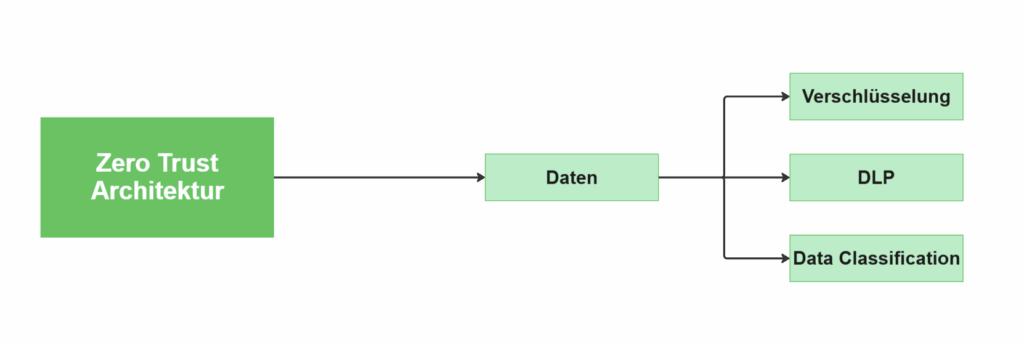

🛡️ Zero-Trust-Architektur

Erfahren Sie, warum das Prinzip „Vertraue niemandem, überprüfe alles“ zum neuen Standard wird. Praktische Implementierung von Conditional Access und Mikrosegmentierung.

2. Grundlagen der Datensicherung 🠒 Effektive Backup-Strategien entwickeln

Eine durchdachte Backup-Strategie ist der Kern jeder Datensicherung. Sie definiert, wie, wo und wie oft Ihre Daten gesichert werden, um im Ernstfall eine schnelle und zuverlässige Datenwiederherstellung zu gewährleisten.

2.1 Bevor Sie starten 🠒 Definieren Sie Ihre Ziele (RTO & RPO)

Bevor Sie Backup-Arten oder Speicherorte wählen, müssen Sie zwei fundamentale Fragen beantworten. Diese Kennzahlen sind entscheidend für die Gestaltung Ihrer gesamten Strategie.

Recovery Time Objective (RTO): Wie schnell müssen Systeme wieder laufen?

Das RTO ist die maximale Zeit, die nach einem Ausfall vergehen darf, bis Ihre Systeme wieder funktionsfähig sein müssen.

Beispiel: Ein RTO von 2 Stunden bedeutet, dass Ihr Geschäftsbetrieb spätestens nach 2 Stunden wieder online sein muss. E-Commerce-Unternehmen haben oft RTOs von unter 1 Stunde, während Buchhaltungssysteme 24-48 Stunden tolerieren können.

Recovery Point Objective (RPO): Wie viel Datenverlust ist akzeptabel?

Das RPO definiert den maximal tolerierbaren Datenverlust, gemessen in Zeit.

Beispiel: Ein RPO von 24 Stunden bedeutet, dass Sie es sich leisten können, die Daten der letzten 24 Stunden zu verlieren. Dies bestimmt direkt, wie oft Sie ein Backup durchführen müssen (mindestens täglich).

📊 Vergleich: Datensicherung vs. Datensicherheit

| Branche | Typisches RTO | Typisches RPO | Backup-Frequenz |

| Produktions- Unternehmen | 8-24 Stunden | 4-12 Stunden | 2-4x täglich |

| Kleine Dienstleister | 24-48 Stunden | 24 Stunden | Täglich |

| E-Commerce | 1-4 Stunden | 1-6 Stunden | Stündlich |

| Finanzdienstleister | 2-8 Stunden | 15 Minuten | Alle 15-30 Minuten |

2.2 Die 3-2-1-Regel 🠒 Der Goldstandard der Datensicherung

Dieses bewährte Prinzip minimiert das Risiko eines Totalverlusts und ist die Grundlage für fast jede robuste Backup-Strategie.

🔢 3 Kopien

Halten Sie immer drei Kopien Ihrer Daten vor (die Originaldaten plus zwei Backups). Redundanz ist der Schlüssel zur Ausfallsicherheit.

💾 2 Medien

Speichern Sie diese Kopien auf zwei unterschiedlichen Medientypen (z. B. interne SSD und externes Cloud-Backup). Unterschiedliche Medien haben unterschiedliche Ausfallrisiken.

🌍 1 externer Ort

Bewahren Sie mindestens eine Backup-Kopie extern (offsite) auf, um sich vor lokalen Katastrophen wie Feuer, Diebstahl oder Naturkatastrophen zu schützen.

Moderne Erweiterung – Die 3-2-1-1-0-Regel

- + 1 immutable Backup (unveränderlich, vor Ransomware geschützt)

- + 0 Fehler bei Wiederherstellungstests

2.3 Backup-Arten im Vergleich 🠒 Voll, Differentiell oder Inkrementell?

Die Wahl der richtigen Backup-Methode hängt von Ihren RTO/RPO-Zielen, dem verfügbaren Speicherplatz und der Netzwerkbandbreite ab.

📋 Backup-Arten im direkten Vergleich

| Backup-Typ | Funktionsweise | Vorteile | Nachteile |

| Vollbackup (Full) | Sichert alle ausgewählten Daten, jedes Mal | Schnelle Wiederherstellung: Alles in einem Set. Einfache Verwaltung: Keine Abhängigkeiten | Langsam & speicherintensiv: Benötigt am meisten Zeit und Platz Hohe Netzwerklast |

| Inkrementelles Backup | Sichert nur Daten, die sich seit dem letzten Backup geändert haben | Sehr schnell & speichersparend: Kleinste Backup-Größe Minimale Netzwerklast | Komplexe Wiederherstellung: Benötigt letztes Vollbackup + alle inkrementellen Backups Längere Ausfallzeiten |

| Differentielles Backup | Sichert alle Daten, die sich seit dem letzten Vollbackup geändert haben | Guter Kompromiss: Schneller als Vollbackup, einfachere Wiederherstellung als inkrementell Nur 2 Dateien nötig | Wächst mit der Zeit: Benötigt mehr Speicher als inkrementelle Backups |

💡 Praxis-Tipp: Die Kraft der Kombination

In der Praxis wird selten nur eine Methode verwendet. Eine typische, effektive Strategie ist:

- Ein wöchentliches Vollbackup (z. B. am Sonntag)

- Tägliche differenzielle oder inkrementelle Backups an den Werktagen

- Stündliche Snapshots für kritische Systeme

Diese hybride Herangehensweise schafft eine gute Balance zwischen Backup-Geschwindigkeit, Speicherbedarf und einfacher Datenwiederherstellung.

2.4 Checkliste 🠒 Ihre robuste Backup-Strategie in 5 Schritten

Nutzen Sie diese Checkliste, um sicherzustellen, dass Sie alle wichtigen Aspekte abdecken:

✅ Schritt 1: Kritische Daten identifizieren

Welche Daten und Systeme sind für Ihr Geschäft überlebenswichtig? Priorisieren Sie diese nach Geschäftskritikalität und Wiederherstellungspriorität.

Kategorisierung:

- Tier 1: Geschäftskritisch (Kundendaten, Transaktionen)

- Tier 2: Wichtig (E-Mails, Dokumente)

- Tier 3: Archivierung (Logs, alte Berichte)

✅ Schritt 2: RTO & RPO festlegen

Definieren Sie klare Ziele für Wiederherstellungszeit und maximalen Datenverlust basierend auf Geschäftsanforderungen.

✅ Schritt 3: Backup-Plan erstellen

Wählen Sie basierend auf RTO/RPO die passenden:

- Backup-Arten (z.B. wöchentlich voll, täglich differentiell)

- Speicherorte (lokal, Cloud-Backup, Offsite gemäß 3-2-1-Regel)

- Backup-Fenster (außerhalb der Geschäftszeiten)

✅ Schritt 4: Sicherheit implementieren

- Verschlüsselung der Backups sowohl bei der Übertragung (in transit) als auch am Speicherort (at rest)

- Zugriffskontrolle: Wer hat Zugriff auf die Backups?

- Immutable Backups: Schutz vor Ransomware-Angriffen

✅ Schritt 5: Regelmäßig testen

Ein ungeprüftes Backup ist kein Backup. Planen Sie regelmäßige Wiederherstellungstests:

- Monatliche Spot-Tests einzelner Dateien

- Quartalsweise Vollwiederherstellung kritischer Systeme

- Jährliche Disaster-Recovery-Übungen

3. Datensicherheit in der Cloud

Lernen Sie Cloud-Sicherheit von Grund auf: Shared Responsibility Model, Best Practices, Zero Trust Implementation und praktische Sicherheitskonfigurationen für AWS, Azure und Google Cloud.

Cloud-Sicherheit ist heute entscheidend für den Geschäftserfolg. Über 90% der Unternehmen nutzen Cloud-Services, doch viele unterschätzen die Sicherheitsrisiken. Dieser Leitfaden zeigt Ihnen, wie Sie Ihre Cloud-Umgebung optimal absichern.

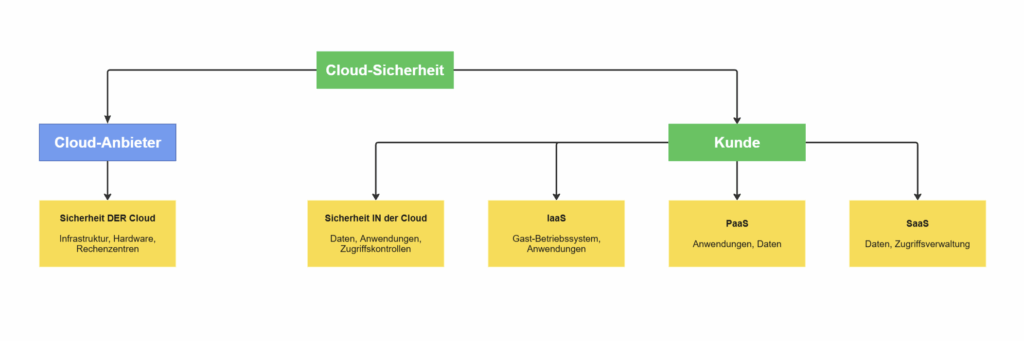

Das Shared Responsibility Model (geteilte Verantwortung) bildet das Fundament der Cloud-Sicherheit. Es definiert klar, welche Sicherheitsaufgaben der Cloud-Anbieter übernimmt und wofür Sie als Kunde verantwortlich sind.

Es ist entscheidend, dieses Modell zu verstehen, um sicherzustellen, dass alle Aspekte der Cloud-Sicherheit abgedeckt sind. Der Cloud-Anbieter ist immer verantwortlich für die Sicherheit DER Cloud

- Physische Rechenzentren

- Hardware (Server, Speicher, Netzwerk)

- Virtualisierungsschicht

- Grundlegende Infrastruktur

Sie als Kunde schützen die Sicherheit IN der Cloud:

- Ihre Daten und Anwendungen

- Zugriffsverwaltung (IAM)

- Netzwerkkonfiguration

- Betriebssystem-Updates

Die genauen Verantwortlichkeiten des Kunden hängen vom genutzten Cloud-Service-Modell ab: Infrastructure as a Service (IaaS), Platform as a Service (PaaS) oder Software as a Service (SaaS).

🖥️ Bei IaaS (z.B. virtuelle Maschinen in AWS EC2, Azure VMs, Google Compute Engine) sind Sie für die Sicherheit in der Cloud verantwortlich. Dazu gehören:

- Gastbetriebssystem und Updates

- Anwendungssicherheit

- Firewall-Konfiguration

- Identitäts- und Zugriffsverwaltung

- Netzwerk-Sicherheitsgruppen

Anbieter-Verantwortung in IaaS (Infrastructure as a Service)

- Hypervisor-Sicherheit

- Physische Infrastruktur

- Netzwerk-Infrastruktur

🔧 Bei PaaS (z.B. Datenbankdienste wie Amazon RDS, Azure SQL Database, Google Cloud SQL; oder Anwendungsplattformen wie AWS Elastic Beanstalk, Azure App Service, Google App Engine) sind als Kunde weiterhin für die Anwendungen verantwortlich

- Anwendungscode

- Datenklassifizierung

- IAM-Konfiguration

- Anwendungsschutz

Der Anbieter übernimmt weiterhin mehr Verantwortung für die Sicherheit der Plattform

- Betriebssystem-Management

- Laufzeitumgebung

- Middleware-Sicherheit

📊 Bei SaaS (z.B. Office 365, Salesforce, Google Workspace) ist der Kunde hauptsächlich für die Sicherheit seiner Daten verantwortlich, einschließlich Klassifizierung und Zugriffskontrolle.

- Benutzerverwaltung

- Datenschutz und -klassifizierung

- Anwendungsspezifische

- Sicherheitseinstellungen

- Compliance-Einhaltung

Der Anbieter ist für die Sicherheit der Anwendung, der Infrastruktur und der Plattform verantwortlich.

- Komplette Anwendungssicherheit

- Infrastruktur-Management

- Plattform-Updates

💡 Praxis-Tipp: Erstellen Sie eine Verantwortungsmatrix für Ihre Cloud-Services. So vermeiden Sie Sicherheitslücken durch unklare Zuständigkeiten.

3.2 Best Practices für Cloud-Sicherheit

Eine mehrschichtige Sicherheitsstrategie ist der Schlüssel zum Schutz Ihrer Cloud-Umgebung. Hier sind die wichtigsten Best Practices:

🎯 1. Asset-Inventarisierung: Kennen Sie Ihre Cloud-Ressourcen

Warum wichtig: Sie können nur schützen, was Sie kennen.

Unternehmen müssen zunächst eine vollständige Bestandsaufnahme aller Cloud-Ressourcen, -Anwendungen und -Daten durchführen. Cloud Security Posture Management (CSPM)-Tools können diesen Prozess durch automatisierte Asset Discovery unterstützen, was die Sichtbarkeit in alle Cloud-Ressourcen, einschließlich nicht verwalteter Anwendungen und Schatten-IT, erhöht.

Sofortmaßnahmen:

- Vollständige Bestandsaufnahme aller Cloud-Ressourcen

- Cloud Security Posture Management (CSPM) Tools implementieren

- Schatten-IT identifizieren und kontrollieren

- Regelmäßige Asset-Discovery automatisieren

Basierend auf diesem Inventar können Organisationen dann Risiken identifizieren und priorisieren, beispielsweise durch Schwachstellenscans und Penetrationstests. Die Nutzung von Threat Intelligence hilft dabei, potenzielle Bedrohungen zu erkennen, proaktive Maßnahmen zu ergreifen und im Falle eines Angriffs schnell und effektiv zu reagieren. Die Remediation sollte in der Reihenfolge von höchstem zu niedrigstem Risiko erfolgen, wobei das Sicherheitsteam Risikominderungspläne entwickelt und deren Wirksamkeit testet . Eine umfassende Cloud-Sicherheitsrichtlinie sollte nicht nur den Zweck der Richtlinie klar definieren, sondern auch die Arten von Daten abdecken, die geschützt werden müssen, wie z.B. finanzielle Daten, sensible und proprietäre Informationen sowie personenbezogene Daten . Darüber hinaus muss die Verantwortlichkeit für die Datensicherheit eindeutig geregelt sein, indem festgelegt wird, für wen die Richtlinie gilt und welche Verantwortlichkeiten die einzelnen Beteiligten tragen.

🔐 2. Verschlüsselung: Daten immer schützen

Bei der Gestaltung von Sicherheitsrichtlinien und -architekturen für die Cloud ist es ratsam, sich an etablierten Frameworks wie der Cloud Security Alliance (CSA) Cloud Controls Matrix (CCM) oder den Center for Internet Security (CIS) Controls zu orientieren.

Verschlüsselung im Ruhezustand:

- AES-256 für sensible Daten verwenden

- Automatische Verschlüsselung aktivieren

- Regelmäßige Schlüsselrotation

Verschlüsselung bei Übertragung:

- TLS 1.3 für alle Datenübertragungen

- End-to-End-Verschlüsselung implementieren

- Sichere API-Kommunikation

Schlüsselverwaltung:

- Hardware Security Modules (HSM) nutzen

- Schlüssel-Lebenszyklus automatisieren

- Prinzip der geringsten Berechtigung anwenden

Zu den grundlegenden Best Practices gehören das Härten von Standardkonfigurationen, die Verschlüsselung von Daten sowohl im Ruhezustand als auch während der Übertragung, die Verwendung von Tokenisierung zur Beschränkung des Zugriffs auf sensible Daten, die Implementierung von Least-Privilege-Zugriffskontrollen und das Verständnis des gemeinsamen Verantwortungsmodells (Shared Responsibility Model).

👥 3. Identitäts- und Zugriffsverwaltung (IAM)

Die Identitäts- und Zugriffsverwaltung (IAM) ist ein weiterer kritischer Bereich. Ein effektives IAM-System ermöglicht die Erstellung effizienter Workflows und stattet Teammitglieder mit den notwendigen Werkzeugen aus, um kritische Assets zu schützen.

Multi-Faktor-Authentifizierung (MFA):

- Für alle Benutzerkonten aktivieren

- Hardware-Token für privilegierte Accounts

- Adaptive Authentifizierung basierend auf Risiko

Least-Privilege-Zugriff:

- Minimale Berechtigungen gewähren

- Regelmäßige Zugriffsprüfungen

- Automatische Deprovisionierung

Rollenbasierte Zugriffskontrolle (RBAC):

- Vordefinierte Rollen verwenden

- Aufgabentrennung implementieren

- Single Sign-On (SSO) einrichten

Die IAM-Checkliste für Cloud-Sicherheit umfasst die Benennung von Stakeholdern mit zugewiesenen Verantwortlichkeiten, die Aktivierung von Single Sign-On (SSO), Zwei-Faktor-Authentifizierung (2FA) und Multi-Faktor-Authentifizierung (MFA), die Automatisierung des Zugriffslebenszyklus sowie die Implementierung einer Aufgabentrennung (Segregation of Duties).

🛡️ 4. Netzwerksicherheit

Darüber hinaus müssen Organisationen geeignete Cloud-Sicherheitstools einsetzen, um Sichtbarkeit, Schutz sowie Bedrohungserkennung und -reaktion zu gewährleisten. Dazu zählen Cloud Access Security Broker (CASB), Cloud Workload Protection Platforms (CWPP), Firewall as a Service (FWaaS), Intrusion Detection/Prevention Systeme (IDS/IPS), Security Information and Event Management (SIEM)-Lösungen und Data Loss Prevention (DLP)-Tools.

Mikrosegmentierung:

- Netzwerk in kleine, isolierte Segmente aufteilen

- Zero-Trust-Prinzipien anwenden

- Lateral Movement verhindern

Firewall-Konfiguration:

- Nur notwendige Ports öffnen

- Regelmäßige Regel-Überprüfung

- Intrusion Detection Systeme (IDS)

📊 5. Überwachung und Compliance

Kontinuierliches Monitoring:

- Security Information and Event Management (SIEM)

- Anomalie-Erkennung implementieren

- Echtzeit-Alerts konfigurieren

Compliance-Management:

- DSGVO, HIPAA, PCI DSS Anforderungen erfüllen

- Regelmäßige Audits durchführen

- Dokumentation aktuell halten

Last but not least – die Integration von Sicherheit in die Cloud-Entwicklung und -Betrieb (DevSecOps) ist ein weiterer kritischer Bestandteil einer umfassenden Cloud-Sicherheitsstrategie.

Unternehmen sollten Sicherheit in den Entwicklungsprozess für Cloud-native Anwendungen integrieren, indem sie DevSecOps-Praktiken implementieren. Dies umfasst die Schulung von Entwicklern in Sicherheitsfragen, die Definition von sicherheitsorientierten Anforderungen, die Automatisierung von Sicherheitstests (SAST, DAST, IAST) in CI/CD-Pipelines und die Verwendung von Infrastructure as Code (IaC), um Konfigurationsfehler zu vermeiden.

💡 IaC-Sicherheitstools wie Checkov können dabei helfen, Schwachstellen in IaC-Konfigurationen (z.B. für Terraform, CloudFormation, Kubernetes) zu erkennen, bevor sie in der Produktion landen, indem sie unsichere Zugriffskontrollen, Richtlinienverstöße und Compliance-Lücken aufdecken.

Da Cloud-Sicherheitsbedrohungen und -umgebungen sich ständig weiterentwickeln, sind kontinuierliche Risikobewertungen und die Aktualisierung der Cloud-Sicherheitstools unerlässlich, um schnell und effektiv auf Sicherheitsvorfälle reagieren zu können.

3.3 Zero Trust in der Cloud 🠒 „Never Trust, Always Verify“

Zero Trust revolutioniert die Cloud-Sicherheit. Statt auf Perimeter-Sicherheit zu vertrauen, wird jeder Zugriff kontinuierlich überprüft.

🔄 Zero Trust Grundprinzipien

1. Identitätszentrierte Sicherheit

- Jede Identität wird als potenzielle Bedrohung betrachtet

- Kontinuierliche Authentifizierung

- Adaptive Sicherheitskontrollen

Das bedeutet, dass jeder Zugriffsversuch – unabhängig davon, ob er aus dem Netzwerk stammt oder nicht – streng authentifiziert und autorisiert werden muss, bevor Zugriff auf Ressourcen gewährt wird. Dieser Ansatz ist besonders relevant für moderne, dynamische Cloud-Umgebungen, in denen Ressourcen wie S3-Buckets, EC2-Instanzen und Lambda-Funktionen ständig skaliert werden und auf komplexe Weise interagieren.

💡Open-Source-Lösungen wie Keycloak bieten robuste Authentifizierungs- und Autorisierungsfunktionen für moderne Anwendungen und Dienste, einschließlich Single Sign-On (SSO), Identity Federation und zentralisierter Benutzerverwaltung über Cloud- und On-Premise-Systeme hinweg.

2. Mikrosegmentierung

- Netzwerk in kleinste Einheiten aufteilen

- Lateral Movement verhindern

- Granulare Zugriffskontrolle

Die Einführung von Zero Trust in diesen Umgebungen zielt darauf ab, die Angriffsfläche zu minimieren, die laterale Bewegung von Bedrohungen innerhalb der Cloud zu verhindern und strengere Zugriffskontrollen für sensible Assets durchzusetzen.

3. Kontinuierliche Überwachung

- Echtzeit-Monitoring aller Aktivitäten

- Verhaltensanalyse implementieren

- Automatische Incident Response

☁️ Zero Trust auf AWS implementieren

Auf AWS kann Zero Trust durch eine Kombination verschiedener Dienste und Praktiken umgesetzt werden. Eine zentrale Rolle spielt AWS Identity and Access Management (IAM), das es Organisationen ermöglicht, Benutzeridentitäten und Berechtigungen granular zu verwalten und das Prinzip der geringsten Rechte (Least Privilege) durchzusetzen.

Identitätsverwaltung:

- AWS IAM für granulare Berechtigungen

- AWS Single Sign-On (SSO) für zentrale Verwaltung

- AWS Verified Access für kontextbasierte Zugriffe

AWS Single Sign-On (SSO) ermöglicht eine zentrale Zugriffsverwaltung und Integration mit externen Identitätsanbietern. Für granulare Zugriffskontrollen können Dienste wie AWS Verified Access genutzt werden.

Netzwerksicherheit:

- Amazon VPC Lattice für Service-Mesh

- Security Groups für Mikrosegmentierung

- AWS WAF für Anwendungsschutz

Die Mikrosegmentierung des Netzwerks, beispielsweise durch Amazon VPC Lattice und Security Groups, hilft, die laterale Ausbreitung von Bedrohungen einzuschränken.

Überwachung:

- AWS CloudTrail für Audit-Logs

- Amazon GuardDuty für Bedrohungserkennung

- AWS Security Hub für zentrale Übersicht

Kontinuierliche Überwachung und Bedrohungserkennung werden durch Dienste wie AWS CloudTrail und Amazon GuardDuty gewährleistet. AWS Key Management Service (KMS) dient der Verschlüsselung von Daten.

Die Implementierung von Zero Trust auf AWS folgt typischerweise einem mehrstufigen Plan, der die Bewertung der aktuellen Umgebung, die Stärkung der Identitätsverwaltung, die Segmentierung des Netzwerks, die Verschlüsselung aller Daten, kontinuierliche Überwachung und Reaktion, Automatisierung sowie die Schulung des Teams umfasst. Cloud Infrastructure Entitlement Management (CIEM)-Tools können dabei helfen, übermäßige Berechtigungen zu identifizieren und zu reduzieren.

🔵 Zero Trust auf Google Cloud

Auch die Google Cloud Platform (GCP) bietet umfangreiche Möglichkeiten zur Implementierung von Zero-Trust-Prinzipien.

Identitätsmanagement:

- Cloud Identity für Benutzerverwaltung

- Identity-Aware Proxy (IAP) für kontextbasierte Zugriffe

- Multi-Faktor-Authentifizierung für alle Konten

Ein zentraler Aspekt ist die Identitäts- und Zugriffsverwaltung (IAM), die es ermöglicht, präzise zu steuern, wer welche Ressourcen unter welchen Bedingungen nutzen darf. Durch die konsequente Anwendung des Least-Privilege-Prinzips in GCP IAM können unnötige Zugriffsrechte minimiert werden. Für eine stärkere Authentifizierung sollte Multi-Faktor-Authentifizierung (MFA) für alle Benutzerkonten aktiviert werden. GCP bietet zudem Dienste wie Identity-Aware Proxy (IAP), der den Zugriff auf Anwendungen basierend auf Benutzeridentität und Kontext gewährt.

Netzwerksicherheit:

- VPC Service Controls für Perimeter-Sicherheit

- Cloud Armor für DDoS-Schutz

- Binary Authorization für Container-Sicherheit

Die Netzwerksegmentierung kann in GCP durch Virtual Private Cloud (VPC)-Netzwerke, Subnetze und Firewall-Regeln erreicht werden.

Überwachung:

- Security Command Center für Sicherheitsübersicht

- Cloud Security Scanner für Schwachstellen

- Forseti Security für Compliance-Monitoring

Für die kontinuierliche Überwachung und Protokollierung von Aktivitäten stehen Dienste wie Cloud Audit Logs und Security Command Center zur Verfügung. Die Verschlüsselung von Daten, sowohl im Ruhezustand (z.B. mit Cloud KMS) als auch während der Übertragung, ist ein weiterer wesentlicher Bestandteil. Darüber hinaus können fortschrittliche Sicherheitstechnologien wie Confidential Computing, das Daten auch während der Verarbeitung schützt, in eine Zero-Trust-Strategie integriert werden.

💡Für das Management von Geheimnissen bietet HashiCorp Vault eine Open-Source-Lösung.

🟡 Zero Trust für SAP Cloud

Im SAP-Umfeld, insbesondere für SAP Cloud-Lösungen wie SAP Business Technology Platform (SAP BTP), SAP S/4HANA Cloud und SAP SaaS-Anwendungen, gewinnt Zero Trust zunehmend an Bedeutung, um komplexe und hybride Landschaften zu sichern.

SAP-spezifische Implementierung:

- SAP Identity Authentication Service (IAS) für zentrale Authentifizierung

- SAP BTP Subaccounts für Isolation

- SAP Enterprise Threat Detection für Monitoring

Kernpfeiler von Zero Trust für SAP Cloud umfassen Identity and Access Management (IAM) mit Diensten wie SAP Identity Authentication Service (IAS) und Identity Provisioning Service (IPS), Gerätesicherheit durch MDM-Richtlinien, Least-Privilege-Zugriff mittels Rollensammlungen in SAP BTP, Mikrosegmentierung durch Subaccounts und Verzeichnisse, kontinuierliche Überwachung mit Audit-Logs und SAP Enterprise Threat Detection sowie allgegenwärtige Verschlüsselung.

Best Practices:

- Identity-First Security implementieren

- Rollensammlungen für Least-Privilege

- Audit-Logs kontinuierlich überwachen

Die Implementierung von Zero Trust in SAP Cloud beinhaltet eine identitätsbasierte Sicherheit (Identity-First Security) durch Zentralisierung der Benutzerauthentifizierung mit SAP IAS, Integration mit Unternehmens-IdPs und die Einführung von MFA für alle SAP Cloud-Benutzer. Mikrosegmentierung kann in SAP BTP durch die Erstellung separater Subaccounts erreicht werden. Richtlinienbasierter Zugriff wird durch Automatisierung der Bereitstellung und Deprovisionierung mit SAP IPS ermöglicht. Zscaler Private Access (ZPA) kann beispielsweise nativ in RISE-with-SAP-Umgebungen integriert werden, um sicheren, VPN-freien Zugriff zu ermöglichen.

💡 Open Source Tools wie Zeek bieten tiefe Einblicke in die Netzwerkaktivitäten, während Cloud Security Suite Schwachstellen in Cloud-Umgebungen aufdeckt.

3.4 Praktische Sicherheitskonfigurationen 🠒 Plattform-spezifische Lösungen

Jede Cloud-Plattform bietet spezifische Sicherheitstools. Hier sind die wichtigsten Konfigurationen:

🟧 AWS Sicherheits-Toolkit

| Tool | Zweck | Konfiguration |

| IAM | Zugriffsverwaltung | Least-Privilege-Prinzip, MFA aktivieren |

| VPC | Netzwerk-Isolation | Private Subnetze, NACLs konfigurieren |

| GuardDuty | Bedrohungserkennung | 24/7 Monitoring, Custom Rules |

| KMS | Schlüsselverwaltung | Automatische Rotation, HSM-Backed Keys |

| CloudTrail | Audit-Logging | Alle Regionen, S3-Verschlüsselung |

🔷 Azure Security Center

| Tool | Zweck | Konfiguration |

| Azure AD | Identitätsmanagement | Conditional Access, PIM |

| Security Center | Posture Management | Secure Score, Recommendations |

| Azure Policy | Governance | Compliance Policies, Deny Rules |

| Key Vault | Geheimnismanagement | Access Policies, Soft Delete |

🟩 Google Cloud Security Suite

| Tool | Zweck | Konfiguration |

| Cloud Identity | Benutzerverwaltung | SSO, 2FA, Groups |

| VPC Service Controls | Perimeter-Sicherheit | Service Perimeters, Access Levels |

| Security Command Center | Threat Detection | Findings, Assets, Sources |

🔒 Universelle Sicherheitsmaßnahmen

Verschlüsselung:

- AES-256 für alle sensiblen Daten

- TLS 1.3 für Datenübertragung

- End-to-End-Verschlüsselung für kritische Workloads

Netzwerksicherheit:

- Virtual Private Clouds (VPCs) für Isolation

- Network Security Groups für Traffic-Kontrolle

- Web Application Firewalls (WAF) für Anwendungsschutz

Überwachung:

- SIEM-Integration für zentrale Logs

- Anomalie-Erkennung automatisieren

- Incident Response Playbooks erstellen

Zusammenfassend lässt sich sagen, dass führende Cloud-Anbieter umfassende IAM-Dienste zur Implementierung rollenbasierter Zugriffskontrollen (RBAC) nach dem Prinzip der geringsten Privilegien bieten. Multi-Faktor-Authentifizierung (MFA) sollte dabei für alle Benutzer – besonders privilegierte Konten – unbedingt aktiviert werden, ergänzt durch regelmäßige Richtlinien-Überprüfungen. Für die Netzwerksicherung kommen virtuelle Firewalls (z. B. Security Groups, NSGs) zur Steuerung des Datenverkehrs zum Einsatz. Sensible Assets erfordern isolierte Umgebungen wie Virtuelle Private Clouds (VPCs). Entscheidend ist zudem die Verschlüsselung von Daten während der Übertragung – besonders in Hybrid- oder Multi-Cloud-Szenarien. Zum Schutz von Webanwendungen vor Exploits dienen spezialisierte Lösungen wie Web Application Firewalls (WAF).

3.5 Expertentipps 🠒 Cloud-Dienste richtig auswählen und absichern

Die Auswahl sicherer Cloud-Dienste erfordert eine strategische Abwägung von Funktionalität, Kosten und Sicherheit.

📋 1. Anforderungsanalyse

Definieren Sie zunächst klare Unternehmensanforderungen: Datenklassifizierung (sensibel/öffentlich), Compliance-Vorgaben (DSGVO, HIPAA, PCI DSS) sowie Leistungs- und Verfügbarkeitsziele.

Datenklassifizierung:

- Öffentliche Daten: Minimale Sicherheitsanforderungen

- Interne Daten: Standardschutz implementieren

- Vertrauliche Daten: Maximale Sicherheitsmaßnahmen

- Regulierte Daten: Compliance-Anforderungen beachten

Compliance-Mapping:

- DSGVO: Datenschutz-Grundverordnung

- HIPAA: Gesundheitsdaten-Schutz

- PCI DSS: Kreditkarten-Sicherheit

- SOX: Finanzberichterstattung

🏆 2. Cloud Service Provider (CSP) Bewertung

Prüfen Sie anschließend Sicherheitsfähigkeiten und Zertifizierungen von Cloud-Providern (z. B. ISO 27001, SOC 2) anhand öffentlicher Dokumente wie Compliance-Handbüchern. Berücksichtigen Sie zukünftig auch EU-weite Standards wie das European Union Cloud Services Scheme (EUCS) der ENISA, das Transparenz und Vergleichbarkeit der Cybersicherheitsniveaus schafft.

Sicherheitszertifizierungen prüfen:

- ISO 27001: Informationssicherheit

- SOC 2 Type II: Kontrollwirksamkeit

- FedRAMP: US-Regierungsstandards

- EUCS: EU Cloud Services Scheme (geplant)

Bewertungskriterien:

- Transparenz der Sicherheitsmaßnahmen

- Incident Response-Fähigkeiten

- Geografische Datenresidenz

- Vendor Lock-in Risiken

🔧 3. Sicherheitskonfiguration

Das Shared Responsibility Model bildet das Fundament der Cloud-Sicherheit. Unternehmen müssen klar zwischen Provider- und Kundenaufgaben trennen. Unabhängig vom Dienstmodell (IaaS/PaaS/SaaS) bleibt der Kunde stets verantwortlich für Datenschutz, Zugriffskontrollen und Compliance. Nutzen Sie daher konsequent die Sicherheitstools des Providers – etwa IAM, Verschlüsselungsdienste, Firewalls und Überwachungssysteme. In Multi-Cloud-Umgebungen gewährleisten CASBs (Cloud Access Security Broker) oder CIEM-Tools (Cloud Infrastructure Entitlement Management) konsistente Richtlinien. Entscheidend ist die Integration von Security by Design und DevSecOps-Praktiken, die Sicherheit von der Architektur bis zum Betrieb durchgängig verankern.

Security by Design:

- Sicherheit von Anfang an planen

- DevSecOps in CI/CD-Pipelines

- Infrastructure as Code (IaC) nutzen

- Automatisierte Sicherheitstests

Continuous Security:

- Vulnerability Scanning automatisieren

- Penetration Testing regelmäßig durchführen

- Security Audits quartalsweise

- Incident Response Plan aktualisieren

🛠️ 4. Empfohlene Tools

Für eine robuste Cloud-Sicherheit sind regelmäßige Audits, Schwachstellen-Scans und Penetrationstests unverzichtbar, um Risiken proaktiv zu identifizieren. Ergänzen Sie dies durch kontinuierliches Monitoring mittels CSPM (Cloud Security Posture Management) und SIEM-Lösungen, die Fehlkonfigurationen und Anomalien in Echtzeit erkennen. Etablieren Sie zwingend einen Cloud-spezifischen Incident-Response-Plan – dokumentiert und regelmäßig getestet – für eine strukturierte Reaktion bei Sicherheitsvorfällen.

Open Source Lösungen:

- Keycloak: Identity Management

- HashiCorp Vault: Secrets Management

- Zeek: Network Monitoring

- Checkov: IaC Security Scanning

Enterprise Tools:

- Cloud Security Posture Management (CSPM)

- Cloud Access Security Broker (CASB)

- Cloud Infrastructure Entitlement Management (CIEM)

- Security Information and Event Management (SIEM)

📊 5. Erfolgsmessung

Mitarbeitersensibilisierung bildet die Basis – doch entscheidend ist die technische Umsetzung. Integrieren Sie Sicherheit direkt in CI/CD-Pipelines, etablieren Sie ein sicheres Geheimnis-Management, und definieren Sie verbindliche RTO/RPO-Kennzahlen für Backup- und Wiederherstellungsprozesse kritischer Cloud-Dienste.

Key Performance Indicators (KPIs):

- Mean Time to Detection (MTTD)

- Mean Time to Response (MTTR)

- Security Posture Score

- Compliance-Rate

Reporting:

- Monatliche Sicherheitsberichte

- Quarterly Business Reviews

- Jährliche Sicherheitsaudits

- Stakeholder-Kommunikation

4. DSGVO-konforme Datensicherung 🠒 Compliance-Leitfaden für Unternehmen

Vollständiger DSGVO-Compliance-Guide für Datensicherung. Praktische Checklisten, rechtliche Anforderungen und technische Umsetzung für sichere Backup-Strategien.

4.1 DSGVO-Relevanz für Ihre Backup-Strategie

Die Datenschutz-Grundverordnung (DSGVO) revolutionierte 2018 den Umgang mit personenbezogenen Daten in der EU. Für Unternehmen bedeutet das: Jedes Backup mit EU-Bürgerdaten unterliegt strengen Compliance-Anforderungen.

Warum DSGVO-konforme Backups kritisch sind

Bußgeldrisiko: Verstöße kosten bis zu:

- 20 Millionen Euro oder

- 4% des weltweiten Jahresumsatzes

Kernpflichten für Backup-Systeme:

✅ Verschlüsselung aller personenbezogenen Daten in Backups

Nach Artikel 5 Absatz 1 Buchstabe f der DSGVO müssen personenbezogene Daten so verarbeitet werden, dass ihre Integrität und Vertraulichkeit gewährleistet ist. Das betrifft auch Backups. Sie müssen verschlüsselt werden, um ihre Vertraulichkeit auch im Ruhezustand zu gewährleisten.

✅ Strenge Zugriffskontrollen auf Backup-Daten

Zugriffsbeschränkungen sind nötig, um sicherzustellen, dass nur autorisiertes Personal auf die gesicherten Daten zugreifen kann (Artikel 5 Absatz 2 DSGVO).

✅ 72-Stunden-Meldepflicht bei Datenschutzverletzungen

Meldepflicht bei Datenschutzverletzungen (Art. 33, 34 DSGVO). Wenn eine Verletzung des Schutzes personenbezogener Daten eintritt, muss der Verantwortliche diese unter bestimmten Umständen innerhalb von 72 Stunden nach Kenntnisnahme der zuständigen Aufsichtsbehörde melden.

✅ Definierte Aufbewahrungsfristen (Speicherbegrenzungsprinzip)

Praxis-Tipp: Verschlüsseln Sie Backups sowohl während der Übertragung (in transit) als auch im Speicher (at rest). Bewahren Sie Schlüssel getrennt von den Backup-Daten auf.

4.2 Die 6 DSGVO-Grundprinzipien für Backup-Strategien

Artikel 5 DSGVO definiert sechs Kernprinzipien, die direkt Ihre Backup-Strategie beeinflussen:

🔒 Rechtmäßigkeit und Transparenz

Was bedeutet das: Backups personenbezogener Daten brauchen eine rechtliche Grundlage

- Einwilligung der betroffenen Person

- Vertragserfüllung

- Rechtliche Verpflichtung

- Berechtigte Interessen

Artikel 5 der DSGVO legt die Grundsätze für die Verarbeitung personenbezogener Daten fest, u. a. die Rechtmäßigkeit, Verarbeitung nach Treu und Glauben, Transparenz. Diese Prinzipien sind wichtig für Datensicherung und -sicherheit. Das erste Prinzip bedeutet: Personenbezogene Daten dürfen nur mit rechtlicher Grundlage verarbeitet werden (z. B. Einwilligung, Vertrag, rechtliche Verpflichtung oder berechtigte Interessen des Verantwortlichen). Im Kontext von Backups bedeutet das: Die Erstellung von Backups mit personenbezogenen Daten erfordert eine solche rechtliche Grundlage und die Verarbeitung muss fair und transparent erfolgen.

Für Backups: Dokumentieren Sie, warum Sie personenbezogene Daten sichern.

✅ Richtigkeit

Was bedeutet das: Daten müssen sachlich richtig und aktuell sein

Gemäß Art. 5 Abs. 1 lit. d DSGVO müssen personenbezogene Daten sachlich richtig und erforderlichenfalls auf dem neuesten Stand sein.

Für Backups: Veraltete/fehlerhafte Daten in Backups können bei Wiederherstellung Probleme verursachen.

🎯 Zweckbindung

Was bedeutet das: Daten nur für festgelegte, legitime Zwecke verwenden

Ein wichtiges Prinzip ist die Zweckbindung (Art. 5 Abs. 1 lit. b DSGVO). Demnach dürfen personenbezogene Daten nur für festgelegte, eindeutige und legitime Zwecke erhoben werden. Eine Weiterverarbeitung in einer mit diesen Zwecken nicht zu vereinbarenden Weise ist nicht zulässig.

Für Backups: Primärzweck ist Wiederherstellung bei Datenverlust – nicht anderweitige Nutzung.

⏰ Speicherbegrenzung

Was bedeutet das: Daten nur so lange speichern wie zweckerforderlich

Gemäß Art. 5 Abs. 1 lit. e DSGVO dürfen personenbezogene Daten nur so lange gespeichert werden, wie es für die Zwecke, für die sie verarbeitet werden, erforderlich ist. Für Backups bedeutet dies, dass Aufbewahrungsfristen definiert werden müssen, die sich an den gesetzlichen Aufbewahrungspflichten und den betrieblichen Erfordernissen orientieren. Alte Backups, die nicht mehr benötigt werden, müssen sicher und endgültig gelöscht werden.

- Berücksichtigen Sie gesetzliche Aufbewahrungspflichten

- Definieren Sie klare Aufbewahrungsfristen

- Implementieren Sie automatische Löschprozesse

📏 Datenminimierung

Was bedeutet das: Nur notwendige Daten verarbeiten

Gemäß dem Prinzip der Datenminimierung (Art. 5 Abs. 1 lit. c DSGVO) müssen personenbezogene Daten dem Zweck angemessen und erheblich sowie auf das für die Zwecke der Verarbeitung notwendige Maß beschränkt sein.

Für Backups: Prüfen Sie, ob alle Daten gesichert werden müssen. Implementieren Sie selektive Backup-Strategien.

🛡️ Integrität und Vertraulichkeit

Was bedeutet das: Angemessene Sicherheit durch technische/organisatorische Maßnahmen

Das Prinzip der Integrität und Vertraulichkeit ist für die Datensicherheit zentral. Es verlangt, dass personenbezogene Daten so verarbeitet werden, dass sie sicher sind. Das bedeutet, sie müssen geschützt werden vor unbefugter oder unrechtmäßiger Verarbeitung, Verlust, Zerstörung oder Schädigung. Dafür braucht es Backups, Sicherheitsmaßnahmen, Verschlüsselung und regelmäßige Tests der Wiederherstellbarkeit. Der Verantwortliche muss die Einhaltung der Grundsätze nachweisen können.

Für Backups:

- Verschlüsselung (AES-256 oder höher)

- Zugriffskontrollen (RBAC, MFA)

- Regelmäßige Wiederherstellungstests

- Integritätsprüfungen (Checksums)

4.3 Verantwortlichkeiten 🠒 Datenverarbeiter vs. Auftragsverarbeiter

🠒 Grundlagen der Rollen (Art. 28 DSGVO)

Artikel 28 der DSGVO regelt die Beziehung zwischen dem Verantwortlichen und dem Auftragsverarbeiter, insbesondere im Kontext von Datensicherung und Cloud-Sicherheit. Der Verantwortliche entscheidet über die Zwecke und Mittel der Verarbeitung von personenbezogenen Daten. Der Auftragsverarbeiter verarbeitet die Daten im Auftrag des Verantwortlichen. Im Kontext von Backups kann ein Unternehmen der Verantwortliche sein, es kann jedoch auch einen externen Dienstleister beauftragen.

| Datenverarbeiter (Controller) | Auftragsverarbeiter (Processor) |

| Entscheidet über Zweck und Mittel | Verarbeitet Daten im Auftrag |

| Ihr Unternehmen bei eigenen Backups | Externer Backup-/Cloud-Dienstleister |

| Trägt Hauptverantwortung | Handelt nach dokumentierten Weisungen |

🠒 Pflichten bei externen Backup-Dienstleistern

✅ Prüfen Sie dessen DSGVO-Compliance

✅ Bewerten Sie technische Sicherheitsmaßnahmen

✅ Fordern Sie Compliance-Zertifikate an

Art. 28 DSGVO verpflichtet Verantwortliche, Auftragsverarbeiter nur bei hinreichenden Garantien für DSGVO-konforme technisch-organisatorische Maßnahmen (TOMs) zu beauftragen. Vor Auftragsvergabe muss deren Compliance-Fähigkeit geprüft werden.

Auftragsverarbeitungsvertrag (AVV) muss enthalten:

📋 Dokumentierte Weisungen zur Datenverarbeitung

🔐 Vertraulichkeitsverpflichtungen für Mitarbeiter

🛡️ Technische Sicherheitsmaßnahmen (Art. 32 DSGVO)

🔄 Regelungen für Subunternehmer

📞 Unterstützung bei Betroffenenanfragen

🚨 Meldepflichten bei Datenschutzverletzungen

🗑️ Löschung/Rückgabe nach Vertragsende

Praxis-Hinweis: Nutzen Sie Cloud-Backup? Dann ist der Anbieter Ihr Auftragsverarbeiter. Ein rechtssicherer AVV ist Pflicht, nicht optional.

4.4 Technische und organisatorische Maßnahmen (TOMs)

🠒 Technische Maßnahmen

Artikel 32 DSGVO verpflichtet Verantwortliche und Auftragsverarbeiter zu risikoadaptierten technisch-organisatorischen Maßnahmen (TOMs). Diese müssen – unter Berücksichtigung von Stand der Technik, Implementierungskosten und Risikoniveau – Schutz vor Datenverlust, unbefugtem Zugriff oder Veränderung bieten.

🔐 Verschlüsselung & Schlüsselmanagement

- At-Rest: AES-256-Verschlüsselung aller Backup-Medien

- In-Transit: TLS 1.3 für Übertragungen

- Schlüsselverwaltung: Hardware Security Modules (HSM)

🛡️ Systemsicherheit

- Verfügbarkeit: 99,9% Uptime für kritische Backups

- Integritätschecks: Regelmäßige Backup-Validierung

- Redundanz: Georedundante Standorte

⚡ Wiederherstellbarkeit

- RTO (Recovery Time Objective): ≤ 4 Std.

- RPO (Recovery Point Objective): ≤ 1 Std. Datenverlust

- Regelmäßige Tests: Monatliche Recovery-Drills

🠒 Organisatorische Maßnahmen

Die Systeme und Dienste müssen dauerhaft verfügbar, vertraulich, integer, belastbar und sicher sein. Bei Zwischenfällen müssen die personenbezogenen Daten schnell wiederhergestellt werden. Der Auftragsverarbeiter löscht oder gibt dem Verantwortlichen die personenbezogenen Daten zurück und stellt alle erforderlichen Informationen bereit. Er ermöglicht und unterstützt Audits. Ein Unternehmen, das einen externen Backup-Dienstleister nutzt, muss einen AV-Vertrag abschließen, der die genannten Anforderungen erfüllt.

🔐 Zugangskontrollen

- RBAC (minimale Berechtigungen)

- MFA für privilegierte Accounts

- Vollständige Protokollierung (Audit-Trails)

� Prozesse & Awareness

- Dokumentierte Backup-Richtlinien

- Quartalsweise Mitarbeiterschulungen

- Incident-Response-Bereitschaft (24/7)

📊 Monitoring & Compliance

- Automatisierte Überwachung mit Alerts

- Jährliche Compliance-Audits

- KPI-Messung der Sicherheitsmaßnahmen

4.5 DSGVO-Compliance-Checkliste 🠒 Backup-Sicherheit

Um die Einhaltung der Datenschutz-Grundverordnung (DSGVO) bei der Datensicherung und -sicherheit zu gewährleisten, können die folgenden Checklisten als Leitfaden dienen. Sie fassen die wichtigsten Punkte zusammen, die Unternehmen beachten sollten, um ihre Backup-Strategien und Sicherheitsmaßnahmen DSGVO-konform zu gestalten.

🔍 Datenaudit durchführen

☐ Alle personenbezogenen Daten in Backups identifizieren

☐ Herkunft, Speicherort und Zugriff dokumentieren

☐ Nicht mehr benötigte Daten löschen

🔒 Basis-Verschlüsselung implementieren

☐ AES-256-Verschlüsselung für alle Backup-Medien

☐ TLS 1.3 für Datenübertragung

☐ Sichere Schlüsselverwaltung einrichten

⛔ Erweiterte Zugangskontrollen

☐ RBAC-System implementieren

☐ MFA für alle Backup-Zugriffe

☐ Vollständige Zugriffsprotokollierung

☐ Regelmäßige Zugriffsüberprüfungen

📜 Rechtliche Compliance

☐ AVV mit externen Dienstleistern abschließen

☐ Rechtsgrundlagen für Backups dokumentieren

☐ Datenschutzfolgenabschätzung durchführen

🔄 Operative Exzellenz

☐ Monatliche Wiederherstellungstests

☐ Automatisierte Integritätsprüfungen

☐ Disaster-Recovery-Szenarien simulieren

📁 Compliance-Dokumentation

☐ Verarbeitungsverzeichnis nach Art. 30 DSGVO

☐ Incident-Response-Plan entwickeln

☐ Mitarbeiterschulungen implementieren

📊 Monitoring & Verbesserung (Kontinuierliche Maßnahmen)

☐ Quartalsweise Compliance-Audits

☐ Jährliche Risikoanalyse

☐ Technologie-Updates implementieren

Download-Tipp: Nutzen Sie unsere detaillierte DSGVO-Checkliste als PDF-Download für eine systematische Umsetzung.

4.6 Datenschutzverletzungen 🠒 Meldepflichten und Incident Response

Die Datenschutz-Grundverordnung (DSGVO) legt strenge Anforderungen an den Umgang mit Verletzungen des Schutzes personenbezogener Daten fest. Eine Datenschutzverletzung liegt vor bei:

🚨 Unbefugter Offenlegung personenbezogener Daten

💥 Unbeabsichtigter Zerstörung oder Verlust

🔓 Unbefugtem Zugriff auf Backup-Systeme

🔄 Unerlaubter Veränderung von Daten

Unternehmen benötigen klare Incident-Response-Verfahren, insbesondere für Backup-Systeme, die häufig Ziele von Ransomware-Angriffen oder Datenverlusten sind. Gemäß DSGVO müssen Cloud-Betreiber bestimmte Datenschutzverletzungen innerhalb von 72 Stunden an die Aufsichtsbehörde (z. B. BfDI) und bei hohem Risiko auch an Betroffene melden. Verstöße können erhebliche Folgen haben wie finanzielle Schäden, Reputationsverlust oder Diskriminierung.

Meldepflichten gemäß DSGVO

Meldung an die Aufsichtsbehörde (Artikel 33 DSGVO)

- Frist: 72 Stunden nach Bekanntwerden

Pflichtangaben:

- Art der Datenschutzverletzung

- Kategorien und Anzahl betroffener Personen

- Kontaktdaten des Datenschutzbeauftragten

- Wahrscheinliche Folgen

- Gegenmaßnahmen

Dies gilt nicht, wenn die Verletzung voraussichtlich kein Risiko für die Rechte und Freiheiten natürlicher Personen darstellt. Bei einer verspäteten Meldung ist die Verzögerung zu begründen.

Meldung an Betroffene (Artikel 34 DSGVO)

- Wann: Bei „hohem Risiko“ für Betroffene

- Frist: Unverzüglich

Inhalte

- Klare, einfache Sprache

- Art der Verletzung

- Wahrscheinliche Folgen

- Schutzmaßnahmen

Führt eine Verletzung des Schutzes personenbezogener Daten voraussichtlich zu einem hohen Risiko für die Rechte und Freiheiten natürlicher Personen, muss der Verantwortliche die betroffenen Personen unverzüglich informieren. Die Mitteilung hat in klarer und einfacher Sprache zu erfolgen.

Incident Response Plan für Backup-Systeme

Die Vorbereitung eines Cloud-Incident-Response-Plans (IR-Plan) ist daher ein wesentlicher Bestandteil der Cloud-Sicherheitsstrategie. Unternehmen mit einem solchen Plan haben im Durchschnitt 55% niedrigere Kosten im Zusammenhang mit Datenpannen als Unternehmen ohne Plan. Ein effektiver Incident-Response-Plan für die Cloud sollte klar spezifizieren, wie auf einen Vorfall zu reagieren ist, wer dafür verantwortlich ist und welche Rollen und Verantwortlichkeiten die Beteiligten im Falle eines Vorfalls haben. Der Plan sollte die Schritte für jede Phase der Incident-Response festlegen:

Phase 1: Vorbereitung

📋 IR-Team mit klaren Rollen definieren

🔧 Monitoring-Tools für Früherkennung

📞 Kontaktlisten (intern/extern) pflegen

🎯 Eskalationsprozesse dokumentieren

Phase 2: Erkennung & Analyse

🚨 Automatische Alerts bei Anomalien

🔍 Forensische Analyse des Vorfalls

📊 Risikobewertung für Betroffene

⏱️ Dokumentation mit Zeitstempel

Phase 3: Eindämmung

🛑 Sofortige Isolation betroffener Systeme

🔐 Passwort-Reset für kompromittierte Accounts

💾 Backup-Validierung unbeschädigter Daten

📢 Interne Kommunikation koordinieren

Phase 4: Wiederherstellung

🔄 Saubere Wiederherstellung aus Backups

🔍 Systemvalidierung vor Freigabe

📈 Verstärktes Monitoring temporär

✅ Normalzustand dokumentiert bestätigen

Phase 5: Nachbereitung

📝 Incident Report erstellen

🔄 Lessons Learned Workshop

📊 Prozess-Verbesserungen implementieren

🎯 Präventionsmaßnahmen verstärken

💡Die Astra Security Suite bietet beispielsweise verschiedene Cybersicherheitsdienste an, die bei der Vorbereitung auf und Reaktion auf Vorfälle helfen können.

Die Beispiele von Datenschutzverletzungen bei Unternehmen wie UniCredit, Adobe und Mercedes-Benz, die zu erheblichen Datenverlusten und potenziellen DSGVO-Bußgeldern führten, unterstreichen die Bedeutung eines proaktiven und robusten Umgangs mit Datenschutzverletzungen. Außerdem können Unternehmen mit etablierten IR-Plänen Datenschutzverletzungen durchschnittlich 73 Tage schneller eindämmen.

Zusammenfassung 🠒 DSGVO-konforme Backup-Strategie

Die 5 Erfolgsfaktoren:

- 🔒 Technische Sicherheit: Verschlüsselung + Zugangskontrollen

- 📋 Rechtliche Compliance: AVV + Dokumentation

- 🔄 Operative Exzellenz: Regelmäßige Tests + Monitoring

- 🚨 Incident Response: Vorbereitung + 72h-Meldepflicht

- 📊 Kontinuierliche Verbesserung: Audits + Schulungen

5. Zero Trust Security 🠒 Moderner Datenschutz ohne Vertrauensvorschuss

Zero Trust Security revolutioniert die Datensicherheit durch kontinuierliche Verifikation. Lernen Sie Implementierungsstrategien, Tools und Best Practices für maximalen Schutz.

5.1 Zero Trust Grundlagen 🠒 Warum traditionelle Sicherheit versagt

Zero Trust basiert auf einem einfachen Grundsatz: „Never Trust, Always Verify“ (Niemals vertrauen, immer überprüfen). Diese Philosophie behandelt jeden Zugriffsversuch als potenzielle Bedrohung – unabhängig davon, ob er aus dem internen Netzwerk stammt.

| Traditionelle Sicherheit | Zero Trust Sicherheit |

| Perimeter-basierter Schutz | Identitätszentrierter Ansatz |

| Vertrauen innerhalb des Netzwerks | Explizite Validierung jedes Zugriffs |

| Einmalige Authentifizierung | Kontinuierliche Überwachung |

| Netzwerk steht im Mittelpunkt | Daten stehen im Mittelpunkt |

Warum Zero Trust heute unverzichtbar ist

Moderne Arbeitsumgebungen haben traditionelle Sicherheitsmodelle überholt:

- Insider-Bedrohungen umgehen traditionelle Firewalls

- Cloud-First Strategien lösen feste Netzwerkgrenzen auf

- Remote Work macht Perimeter-Sicherheit ineffektiv

- Hybrid-Infrastrukturen schaffen neue Angriffsvektoren

Zero Trust hingegen betrachtet keine Benutzer, Geräte oder Anwendungen als inhärent vertrauenswürdig, selbst wenn sie sich bereits innerhalb des Netzwerks befinden. Jeder Zugriff muss explizit validiert werden, wobei der Kontext (z.B. Benutzeridentität, Gerätestatus, Standort) eine entscheidende Rolle spielt. Weitere Kernprinzipien von Zero Trust sind das Prinzip der geringsten Rechte (Least Privilege) und die Mikrosegmentierung.

Das Least-Privilege-Prinzip besagt, dass Benutzern und Geräten nur die minimal notwendigen Berechtigungen gewährt werden sollten, die sie zur Erfüllung ihrer Aufgaben benötigen. Dies minimiert die Angriffsfläche und die potenziellen Auswirkungen kompromittierter Anmeldeinformationen . Mikrosegmentierung bezieht sich auf die Unterteilung des Netzwerks in kleine, isolierte Zonen, um die laterale Bewegung von Angreifern im Falle eines erfolgreichen Eindringens einzuschränken , . Ein weiteres wichtiges Element ist die kontinuierliche Überwachung und Verifizierung. Anstatt sich auf eine einmalige Authentifizierung zu verlassen, überwacht Zero Trust kontinuierlich Benutzer- und Geräteverhalten sowie den Netzwerkverkehr auf Anomalien, um verdächtige Aktivitäten frühzeitig zu erkennen und darauf zu reagieren , . Dies erfordert eine „Assume-Breach“-Mentalität (Annahme eines impliziten Verstoßes), bei der davon ausgegangen wird, dass sich Angreifer bereits im System befinden könnten, und daher kontinuierliche Überprüfungen und ein robustes Sicherheitsmonitoring unerlässlich sind , . Ziel ist es, die Vertraulichkeit, Integrität und Verfügbarkeit von Daten und Ressourcen zu gewährleisten, insbesondere in Cloud-Umgebungen.

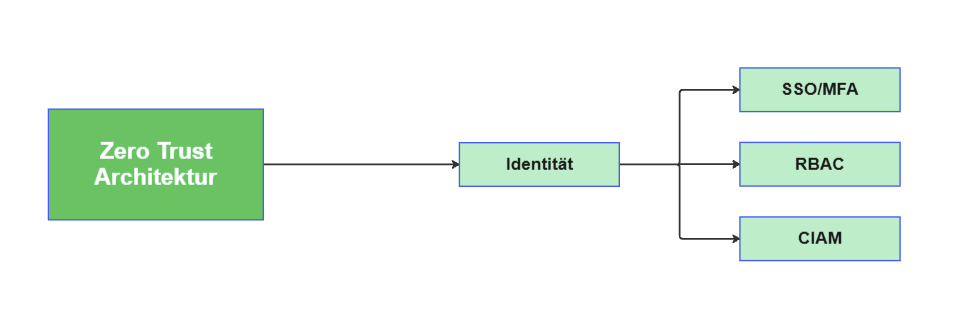

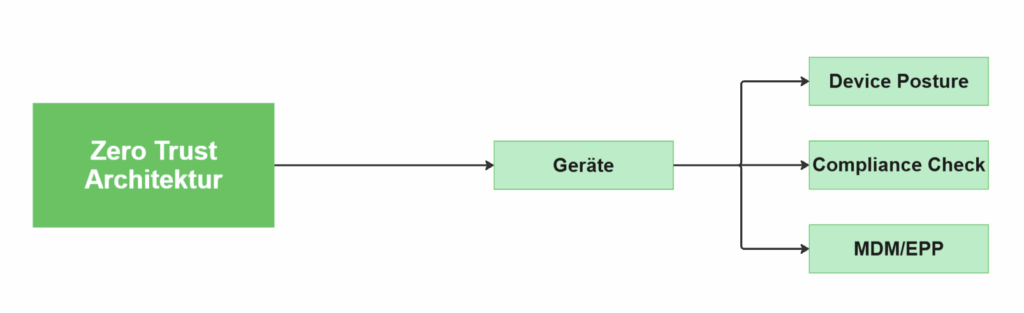

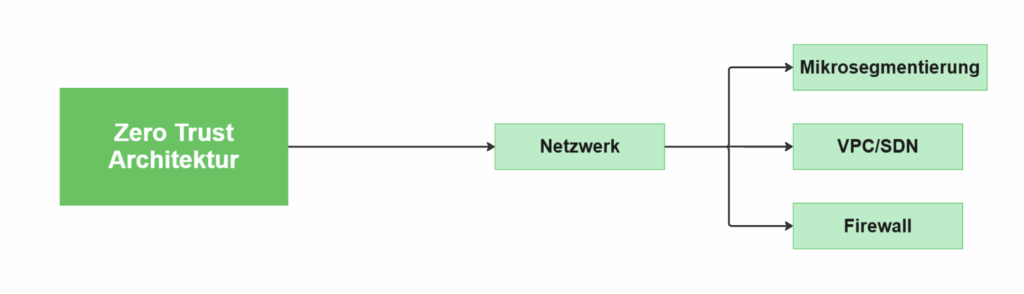

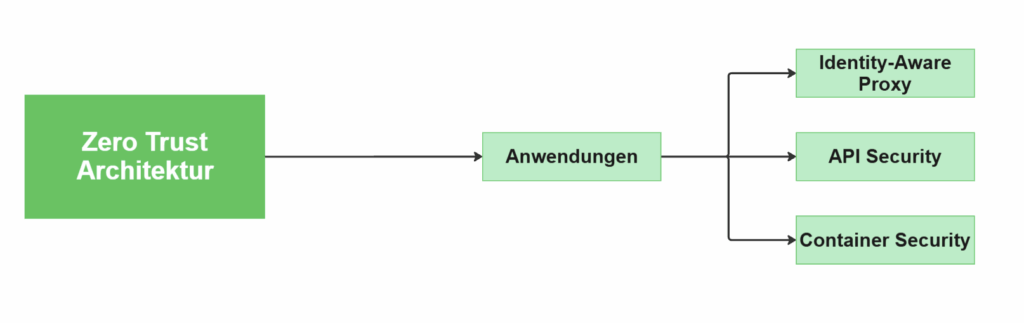

5.2 Schlüsselkomponenten einer Zero-Trust-Architektur

Eine umfassende Zero-Trust-Architektur integriert mehrere Schlüsselkomponenten, die zusammenarbeiten, um ein robustes Sicherheitsmodell zu schaffen.

Die Identität steht im Mittelpunkt von Zero Trust. Starke Identitäts- und Zugriffsverwaltung (IAM) ist entscheidend, um sicherzustellen, dass der Zugriff auf verifizierte Benutzeridentitäten beschränkt ist.

Schlüsselkomponenten:

- Multi-Faktor-Authentifizierung (MFA) für alle Benutzerkonten

- Single Sign-On (SSO) für zentrale Identitätsverwaltung

- Rollenbasierte Zugriffskontrolle (RBAC) nach Least-Privilege-Prinzip

- Kontinuierliche Authentifizierung durch Verhaltensanalyse

Bevor ein Gerät Zugriff erhält, muss dessen Integrität und Konformität mit den Sicherheitsrichtlinien überprüft werden (Device Posture Assessment).

Prüfkriterien:

- Aktuelle Betriebssystem-Updates

- Installierte Sicherheitssoftware

- Compliance mit Unternehmensrichtlinien

- Absence von Malware oder verdächtigen Aktivitäten

Die Netzwerksicherheit im Zero-Trust-Modell basiert auf Mikrosegmentierung und gesicherten Netzwerkverbindungen. Durch Mikrosegmentierung wird das Netzwerk in kleinere, isolierte Zonen unterteilt, was laterale Bewegungen von Angreifern wirksam verhindert.

Mikrosegmentierung teilt Netzwerke in isolierte Zonen auf:

- Verhindert laterale Bewegung von Angreifern

- Begrenzt Schadenspotenzial bei erfolgreichen Angriffen

- Ermöglicht granulare Kontrolle über Datenflüsse

Im Zero-Trust-Modell erfolgt der Zugriff auf Anwendungen nur nach expliziter Validierung und strikter Orientierung am Prinzip der geringsten Rechte. Moderne Lösungen wie Identity-Aware Proxy (IAP) ersetzen die traditionelle Perimeter-basierte Sicherheit durch eine kontextabhängige Zugriffskontrolle, die Benutzeridentität, Gerätestatus und weitere Faktoren berücksichtigt. Dieser Ansatz ermöglicht granulare Berechtigungssteuerung und minimiert gleichzeitig die Angriffsfläche des Systems.

Identity-Aware Proxy (IAP) steuert Anwendungszugriff:

- Validierung basierend auf Benutzeridentität

- Kontextabhängige Zugriffsentscheidungen

- Schutz ohne VPN-Abhängigkeit

Im Zero-Trust-Modell bildet der Datenchutz die entscheidende Sicherheitsebene. Sämtliche Daten – sowohl im Ruhezustand (at rest) als auch in der Übertragung (in transit) – müssen durchgängig verschlüsselt werden. Der Zugriff auf sensible Informationen erfordert strikte Kontrollen, wobei Lösungen wie VPC Service Controls sichere Datenperimeter schaffen und Datenexfiltration verhindern. Zugriffsentscheidungen erfolgen kontextbasiert unter Berücksichtigung von Benutzeridentität, Gerätestatus, Standort und Datenklassifizierung. Adaptive Richtlinien ermöglichen risikogestufte Sicherheitsüberprüfungen, während kontinuierliche Monitoring-Systeme (SIEM/XDR) in Kombination mit Echtzeitanalysen verdächtige Aktivitäten sofort erkennen. Dieser mehrschichtige Ansatz gewährleistet maximalen Datenschutz – von der Prävention bis zur Detektion.

Datenschutz auf allen Ebenen:

- Verschlüsselung im Ruhezustand (at rest) und bei Übertragung (in transit)

- VPC Service Controls für sichere Datenperimeter

- Kontextbewusste Zugriffsrichtlinien basierend auf Datenklassifizierung

5.3 Zero Trust Implementierung 🠒 On-Premise, Cloud und Hybrid

Die Implementierung von Zero Trust erfordert einen ganzheitlichen Ansatz, der verschiedene Sicherheitsebenen kombiniert – es handelt sich nicht um eine einzelne Lösung, sondern um ein integriertes Konzept. Die grundlegenden Prinzipien gelten unabhängig von der Infrastruktur, sei es On-Premise, Cloud oder Hybrid.

Der Prozess beginnt typischerweise mit einer Sicherheitsbewertung, um kritische Assets, Datenflüsse und Zugangspunkte zu identifizieren sowie Berechtigungen und Rollen zu überprüfen. Cloud-Anbieter wie AWS, Azure und Google Cloud bieten hierfür native Zero-Trust-Tools:

Amazon Web Services (AWS):

- AWS IAM für Identitätsverwaltung

- Amazon VPC für Netzwerksegmentierung

- GuardDuty für Bedrohungserkennung

- AWS Verified Access für sicheren Anwendungszugriff

Microsoft Azure:

- Azure Active Directory für Identitätsdienste

- Azure Security Center für Sicherheitsüberwachung

- Azure Policy für Compliance-Durchsetzung

Google Cloud Platform:

- Cloud Identity für Identitätsverwaltung

- VPC Service Controls für Datenperimeter

- BeyondCorp für Zero Trust Zugriff

Diese Lösungen unterstützen identitätsbasierte Zugriffskontrolle, Mikrosegmentierung und kontinuierliche Überprüfung, um eine durchgängige Zero-Trust-Architektur zu gewährleisten.

Hybrid-Umgebungen erfolgreich absichern

In hybriden Infrastrukturen, die On-Premise-Ressourcen und Cloud-Dienste verbinden, bildet eine einheitliche Identitätsverwaltung die zentrale Grundlage. Durch die Integration bestehender Identitätsanbieter wie Active Directory lässt sich eine konsistente Authentifizierung mit Single Sign-On (SSO) über alle Umgebungen hinweg realisieren. Gleichzeitig erfordern die Netzwerkverbindungen zwischen lokalen und Cloud-Systemen besondere Absicherung, etwa durch Cloud Interconnect oder IPsec-VPNs.

Auch in On-Premise-Umgebungen gelten die Kernprinzipien von Zero Trust.

Herausforderungen:

- Einheitliche Identitätsverwaltung über alle Umgebungen

- Sichere Verbindungen zwischen On-Premise und Cloud

- Konsistente Sicherheitsrichtlinien

Lösungsansätze:

- Active Directory Federation für nahtlose Identitätsverwaltung

- Cloud Interconnect und IPsec-VPNs für sichere Verbindungen

- Infrastructure as Code (IaC) für konsistente Konfigurationen

5.4 Praxiserprobte Zero Trust Tools und Technologien

Die erfolgreiche Implementierung von Zero Trust erfordert eine Kombination bewährter Sicherheitspraktiken und moderner Technologien.

Für die Netzwerksicherheit kommen Virtual Private Cloud (VPC), Next-Generation Firewalls (z.B. Palo Alto VM-Series), NACLs und Software-Defined Networking (SDN) zum Einsatz. In Google Cloud ermöglichen Shared VPC und VPC Service Controls eine effektive Segmentierung und Absicherung sensibler Datenperimeter. Cloud Interconnect und IPsec-VPNs sichern Verbindungen, während Private Service Connect den geschützten Zugriff auf Cloud-Dienste gewährleistet. Gegen DDoS-Angriffe und Web-Bedrohungen bietet Google Cloud Armor robusten Schutz.

| Tool-Kategorie | Beispiele | Einsatzbereich |

| Firewalls | Palo Alto NGFW, Fortinet | Netzwerksegmentierung |

| SASE-Lösungen | Zscaler, Netskope | Secure Access Service Edge |

| SD-WAN | Cisco Viptela, VMware VeloCloud | Sichere WAN-Verbindungen |

Im Bereich Identitäts- und Zugriffsmanagement (IAM) sind Single Sign-On (SSO), Multi-Faktor-Authentifizierung (MFA) und Identity-Aware Proxy (IAP) essenziell. Google Cloud unterstützt die Integration externer Identitätsanbieter und bietet mit Cloud Identity Premium eine eigene Lösung. Für die Workload-Authentifizierung dienen OAuth 2.0 oder JSON Web Tokens (JWTs).

Führende IAM-Lösungen:

- Okta für umfassende Identitätsdienste

- Microsoft Azure AD für Microsoft-Umgebungen

- Ping Identity für Enterprise-Anforderungen

Die kontinuierliche Überwachung erfolgt durch SIEM/XDR-Lösungen sowie Cloud-spezifische Tools wie Google Security Operations und Security Command Center Enterprise. Network Analyzer und Web Security Scanner analysieren Netzwerksicherheit und Schwachstellen, während Cloud IDS und Cloud NGFW Angriffe abwehren.

EDR/XDR-Lösungen:

- CrowdStrike Falcon für Endpoint Detection

- SentinelOne für KI-basierte Bedrohungsabwehr

- Microsoft Defender für integrierte Sicherheit

Die Automatisierung mittels Infrastructure as Code (IaC) mit Terraform, Jenkins oder Cloud Build stellt konsistente Sicherheitskonfigurationen sicher. Praxisbeispiele zeigen die Umsetzung in Google Kubernetes Engine (GKE) durch Cloud Service Mesh (Istio) mit mTLS-Verschlüsselung und Namespace-Isolation, oder die Nutzung von Terraform für minimale IAM-Berechtigungen, Binary Authorization und Cloud Armor.

SIEM/SOAR-Plattformen:

- Splunk für umfassende Sicherheitsanalyse

- IBM QRadar für Enterprise-Umgebungen

- Google Security Operations (ehemals Chronicle)

Cloud-Anbieter vereinfachen die Implementierung durch integrierte Lösungen wie AWS Verified Access, Google BeyondCorp und Microsofts Zero Trust Framework. Für Gerätesicherheit sorgen MDM-/EDR-Lösungen (Microsoft Intune, CrowdStrike), während Software-Defined Perimeter (SDP)-Technologien von Zscaler oder Palo Alto Networks direkten, abgesicherten Anwendungszugriff ermöglichen.

5.5 Zero Trust Einführung 🠒 5-Stufen-Roadmap

Die Einführung von Zero Trust ist ein iterativer Prozess und kein einmaliges Projekt. Beginnen Sie mit einer gründlichen Planung und Bewertung. Zunächst sollten die Ziele und der Umfang der Zero-Trust-Implementierung definiert werden, einschließlich der identifizierten kritischen Anwendungen, Daten, Assets und Dienste (Protect Surface)

Phase ① 🠒 Baseline-Assessment

Ziel: Aktuellen Sicherheitsstatus verstehen

☐ Kritische Assets und Daten identifizieren

☐ Bestehende Zugangspunkte kartieren

☐ Benutzerrollen und Berechtigungen auditieren

☐ Transaktionsflüsse dokumentieren

Ergebnis: Sicherheitsbasisbewertung mit Risikobewertung

Durch eine Sicherheitsbasisbewertung wird der Status ermittelt und kritische Assets identifiziert. Es werden Zugangspunkte und Vertrauensbeziehungen abgebildet sowie Benutzerrollen und Berechtigungen überprüft. Die Transaktionsflüsse der Anwendungen müssen analysiert werden. Basierend auf dieser Analyse kann eine Roadmap erstellt werden.

Phase ② 🠒 Identitätsverwaltung stärken

Ziel: Robuste Authentifizierung etablieren

☐ MFA für alle Benutzerkonten aktivieren

☐ SSO-Lösung implementieren

☐ Least-Privilege-Prinzip durchsetzen

☐ Privilegierte Konten besonders absichern

Ergebnis: Zentrale Identitätsverwaltung mit MFA

Konsequente Anwendung des Prinzips der geringsten Rechte (Least Privilege) ist essenziell – und zwar durchgängig für Benutzer, Geräte und Anwendungen. Die Umsetzung dieser Maßnahmen erfordert regelmäßige Überprüfungen und Anpassungen an sich ändernde Anforderungen.

Phase ③ 🠒 Netzwerk segmentieren

Ziel: Mikrosegmentierung für kritische Workloads

☐ Kritische Anwendungen isolieren

☐ Firewall-Regeln für Mikrosegmente definieren

☐ Netzwerkverkehr zwischen Segmenten kontrollieren

☐ Zero Trust Network Access (ZTNA) implementieren

Ergebnis: Segmentiertes Netzwerk mit kontrollierten Zugriffen

Parallel dazu ist der Aufbau einer konsistenten Sicherheitsarchitektur essenziell, die nahtlos On-Premise-Systeme, Cloud-Ressourcen und SaaS-Anwendungen integriert. Diese ganzheitliche Herangehensweise verhindert Sicherheitslücken durch Architekturfragmentierung und gewährleistet einheitliche Schutzmechanismen über alle Umgebungen hinweg.

Phase ④ 🠒 Monitoring aktivieren

Ziel: Kontinuierliche Überwachung und Bedrohungserkennung

☐ SIEM/XDR-Lösung deployment

☐ Audit-Logging für alle Zugriffe aktivieren

☐ Anomalie-Erkennung konfigurieren

☐ Incident Response Prozesse definieren

Ergebnis: 24/7 Sicherheitsmonitoring mit automatisierter Bedrohungserkennung

Moderne SIEM- und XDR-Systeme spielen eine Schlüsselrolle, indem sie Sicherheitsereignisse korrelieren und automatisierte Gegenmaßnahmen einleiten. Zur Aufrechterhaltung der Betriebsbereitschaft empfehlen sich regelmäßige Disaster-Recovery-Tests, die die Belastbarkeit der Sicherheitsinfrastruktur validieren.

Phase ⑤ 🠒 Sicherheitskultur entwickeln

Ziel: Zero Trust Mindset in der Organisation verankern

☐ Mitarbeiter-Schulungen zu Zero Trust Prinzipien

☐ Phishing-Simulationen durchführen

☐ Sicherheits-Champions in Teams etablieren

☐ Kontinuierliche Verbesserungsprozesse implementieren

Ergebnis: Sicherheitsbewusste Organisation mit Zero Trust Kultur

„Security ist kein Produkt, sondern ein Prozess“ – dieser Grundsatz gilt besonders für die erfolgreiche Zero-Trust-Implementierung. Diese ganzheitliche Betrachtung stellt sicher, dass Zero Trust nicht nur implementiert, sondern auch nachhaltig gelebt wird.

Erfolgsmessung und kontinuierliche Optimierung von Zero Trust

Die Implementierung von Zero Trust erfordert klare Messgrößen, um den Fortschritt zu bewerten und Schwachstellen zu identifizieren. Dabei sollten sowohl technische Kennzahlen als auch geschäftliche Auswirkungen betrachtet werden:

📈 Technische KPIs

- Mean Time to Detection (MTTD): Misst, wie schnell Bedrohungen erkannt werden

- Mean Time to Response (MTTR): Zeigt die Effizienz der Reaktion auf Vorfälle

- Privileged Access Reduction: Dokumentiert die Reduzierung überflüssiger Berechtigungen

- Network Segmentation Coverage: Gibt an, wie viele kritische Workloads isoliert sind

💼 Business-KPIs

- Compliance-Rate: Überprüfung der Einhaltung von Vorgaben (DSGVO, HIPAA, etc.)

- Security ROI: Berechnung der Kosteneinsparungen durch verhinderte Sicherheitsvorfälle

- User Experience Score: Bewertung der Akzeptanz bei den Nutzern

Häufige Fallstricke vermeiden

Bei der Umsetzung sollten folgende Risiken beachtet werden:

- „Big Bang“ Approach: Schrittweise Einführung ist erfolgreicher

- Benutzerfreundlichkeit ignorieren: Balance zwischen Sicherheit und Usability

- Legacy-Systeme vernachlässigen: Auch alte Systeme müssen integriert werden

- Unzureichende Schulungen: Mitarbeiter müssen das neue Modell verstehen

- Fehlende Governance: Klare Verantwortlichkeiten und Prozesse definieren

Diese Kennzahlen und Learnings helfen, Zero Trust nicht nur einzuführen, sondern auch langfristig erfolgreich zu betreiben.

6. Datenwiederherstellung (Recovery) und Notfallplanung

6.1 Disaster Recovery Plan (DRP) 🠒 Warum jedes Unternehmen einen braucht

Ein Disaster Recovery Plan (DRP) ist Ihr Notfallplan für den Fall, dass IT-Systeme ausfallen oder Daten verloren gehen. Er definiert konkrete Schritte, um nach einem Ausfall schnell wieder arbeitsfähig zu sein.

Die Kosten ohne Disaster Recovery Plan

Ohne DRP drohen Ihrem Unternehmen:

- Datenverluste bis zu 100% kritischer Geschäftsdaten

- Ausfallzeiten von mehreren Tagen bis Wochen

- Finanzielle Schäden durch Produktionsausfall

- Reputationsschäden bei Kunden und Partnern

- Rechtliche Konsequenzen bei DSGVO-Verstößen

Praxis-Tipp: Studien zeigen, dass 40% der Unternehmen nach einem großen Datenverlust ohne DRP innerhalb von 5 Jahren schließen müssen.

Was ein effektiver DRP beinhaltet

Ein wirksamer Disaster Recovery Plan (DRP) entsteht durch systematische Vorbereitung. Den Ausgangspunkt bilden zwei zentrale Analysen. Die Risikoanalyse bewertet potenzielle Bedrohungen und ihre Eintrittswahrscheinlichkeit, während die Business Impact Analysis (BIA) die finanziellen und operativen Folgen von Ausfällen kritischer Geschäftsprozesse quantifiziert. Diese Untersuchungen bilden die Basis für die Festlegung der Recovery Time Objectives (RTO) und Recovery Point Objectives (RPO), die wiederum die Auswahl geeigneter Wiederherstellungsstrategien und -technologien bestimmen.

Technische Komponenten:

- Backup-Strategien für verschiedene Datentypen

- Wiederherstellungsverfahren für Systeme und Anwendungen

- Alternative IT-Infrastruktur (Hot Sites, Cold Sites)

Organisatorische Aspekte:

- Notfallteam mit klaren Verantwortlichkeiten

- Kommunikationspläne für Mitarbeiter und Kunden

- Eskalationswege bei verschiedenen Notfallszenarien

Ein umfassender DRP beschränkt sich nicht auf technische Wiederherstellungsverfahren, sondern integriert auch klare Kommunikationsprozesse für Mitarbeiter, Kunden und Partner sowie Richtlinien für die Öffentlichkeitsarbeit. Entscheidend für die Praxiswirksamkeit sind regelmäßige Tests und Anpassungen des Plans, die sicherstellen, dass er sowohl mit der evolutionären Geschäftsentwicklung als auch mit der dynamischen Bedrohungslandschaft Schritt hält. Moderne IT Disaster Recovery Planungssoftware kann diesen Prozess unterstützen, indem sie Wiederherstellungsprozesse automatisiert und Testläufe systematisiert.

Von der Risikoanalyse zum fertigen Plan

Schritt 1: Risikoanalyse

- Identifizieren Sie potenzielle Bedrohungen (Ransomware, Naturkatastrophen, Hardwareausfälle)

- Bewerten Sie die Eintrittswahrscheinlichkeit

Schritt 2: Business Impact Analysis (BIA)

- Quantifizieren Sie die finanziellen Auswirkungen von Ausfällen

- Priorisieren Sie kritische Geschäftsprozesse

Schritt 3: Ziele definieren

- Legen Sie Recovery Time Objectives (RTO) fest

- Bestimmen Sie Recovery Point Objectives (RPO)

6.2 RTO und RPO 🠒 Die wichtigsten Kennzahlen für Ihre Disaster Recovery

RTO und RPO sind die Grundlage jeder Disaster Recovery-Strategie. Sie bestimmen, wie schnell Ihre Systeme wieder laufen müssen und wie viel Datenverlust akzeptabel ist.

🕧 Recovery Time Objective (RTO) – Wie schnell müssen Sie wieder online sein?

Definition: Die maximale Zeit, die ein System nach einem Ausfall offline bleiben darf.

Beispiele aus der Praxis:

- Backup-System: RTO = 24 Stunden (läuft im Hintergrund)

- E-Commerce-Shop: RTO = 1 Stunde (jede Minute Ausfall kostet Umsatz)

- Interne E-Mail: RTO = 4 Stunden (weniger geschäftskritisch)

⚙️ Recovery Point Objective (RPO) – Wie viel Datenverlust können Sie verkraften?

Definition: Die maximale Menge an Daten, die bei einem Ausfall verloren gehen darf.

Beispiele für verschiedene RPO-Anforderungen:

- Finanztransaktionen: RPO = 0 Minuten (kein Datenverlust erlaubt)

- Kundendatenbank: RPO = 15 Minuten (kurze Backups-Intervalle)

- Archivdaten: RPO = 24 Stunden (tägliche Backups ausreichend)

RTO und RPO in der Backup-Strategie umsetzen

Im Rahmen der Notfallplanung bilden die Recovery Time Objective (RTO) und Recovery Point Objective (RPO) entscheidende Steuerungsgrößen für die Geschäftskontinuität.

Die RTO bestimmt die maximale tolerierbare Ausfallzeit eines Systems oder Prozesses, bevor kritische Geschäftsauswirkungen eintreten. Diese Kennzahl hat direkte Konsequenzen für die Infrastrukturkosten – je kürzer die vorgegebene RTO, desto aufwändiger und teurer die erforderlichen Wiederherstellungsmaßnahmen. Ein E-Commerce-Betreiber etwa wird für seine Zahlungsabwicklung eine extrem niedrige RTO (potenziell Minuten) ansetzen, während Backoffice-Systeme längere Toleranzfenster haben können.

Als zentrale Kennzahl der Notfallplanung bestimmt die Recovery Point Objective (RPO), welches Datenverlustfenster ein Unternehmen maximal akzeptieren kann. Gemessen in Zeiteinheiten legt die RPO fest, wie weit die letzte verfügbare Datensicherung oder Replikation zurückliegen darf – ein RPO von einer Stunde bedeutet entsprechend einen potenziellen Datenverlust von bis zu 60 Minuten.

| RTO/RPO-Anforderung | Backup-Strategie | Technologie-Beispiel |

| RTO < 1h, RPO < 15min | Echtzeitreplikation | Synchrone Spiegelung |

| RTO < 4h, RPO < 1h | Häufige Backups | Inkrementelle Backups alle 15min |

| RTO < 24h, RPO < 12h | Standardbackups | Tägliche Vollsicherung |

Kostenfaktor: Niedrigere RTO/RPO-Werte = höhere Kosten für Backup-Infrastruktur

6.3 Backup-Tests 🠒 Ein nicht getestetes Backup ist kein Backup

Die Wirksamkeit von Datensicherungslösungen steht und fällt mit ihrer regelmäßigen Überprüfung – eine oft unterschätzte, aber essentielle Praxis. Denn selbst das technisch ausgefeilteste Backup-System bietet keine Garantie, wenn die Wiederherstellungsprozesse nicht konsequent validiert werden.

Häufige Probleme ohne Tests:

- Unvollständige Backups (fehlende Dateien oder Datenbanken)

- Korrupte Backup-Dateien (nicht mehr lesbar)

- Zu lange Wiederherstellungszeiten (RTO wird nicht erreicht)

- Fehlende Berechtigungen bei der Wiederherstellung

- Inkompatible Backup-Formate nach Software-Updates

Umfassende Teststrategie

Effektive Tests sollten verschiedene Szenarien abdecken:

1. Datei-Wiederherstellung (einfachster Test)

- Einzelne Datei aus Backup wiederherstellen

- Vergleich mit Original auf Vollständigkeit

- Häufigkeit: Monatlich

2. Verzeichnis-Wiederherstellung

- Kompletten Ordner mit Unterstruktur wiederherstellen

- Prüfung von Dateiberechtigungen und Timestamps

- Häufigkeit: Quartalsweise

3. System-Wiederherstellung (Bare-Metal-Recovery)

- Komplettes System auf neuer Hardware wiederherstellen

- Test aller Anwendungen und Services

- Häufigkeit: Halbjährlich

4. Disaster-Szenario-Tests

- Simulation spezifischer Ausfallszenarien (Ransomware, Naturkatastrophe)

- Test der kompletten Disaster Recovery-Prozedur

- Häufigkeit: Jährlich

Idealerweise erfolgen diese Tests in isolierten Umgebungen, um Produktionssysteme nicht zu beeinträchtigen und den gesamten Recovery-Prozess – von der Medienidentifikation bis zur vollständigen Systemverfügbarkeit – validieren zu können.

Test-Dokumentation und Optimierung

Für hochverfügbare Systeme empfehlen sich wöchentliche oder monatliche Tests, während weniger kritische Anwendungen viertel- oder halbjährliche Überprüfungen benötigen. Sämtliche Testergebnisse – inklusive Wiederherstellungsdauer, aufgetretener Probleme und eingeleiteter Verbesserungsmaßnahmen – sind sorgfältig zu dokumentieren. Diese Aufzeichnungen dienen sowohl Compliance-Zwecken als auch der kontinuierlichen Optimierung der Backup-Strategie.

Dokumentieren Sie bei jedem Test:

- Dauer der Wiederherstellung (Vergleich mit RTO)

- Aufgetretene Probleme und deren Lösungen

- Vollständigkeit der wiederhergestellten Daten

- Verbesserungsvorschläge für zukünftige Tests

Moderne Backup-Lösungen mit integrierten Tests:

- Zerto: Nicht-disruptive Test-Failover ohne Produktionsunterbrechung

- Veeam: Automatisierte Backup-Verifikation

- Acronis: Instant Recovery mit Test-Umgebung

Unabhängig von den eingesetzten Tools sollte das Backup-Testing als fester Bestandteil der IT-Betriebsprozesse etabliert werden – nur so lässt sich im Ernstfall die Geschäftskontinuität tatsächlich gewährleisten.

6.4 Checkliste 🠒 Disaster Recovery Plan erstellen

Die Erstellung eines umfassenden Disaster Recovery Plans (DRP) erfordert sorgfältige Planung und Berücksichtigung zahlreicher Faktoren. Eine Checkliste kann dabei helfen, keine wichtigen Aspekte zu übersehen.

Disaster Recovery Plan Checkliste

✅ Phase 1: Grundlagen definieren

🎯Ziele und Umfang definieren

Identifizierung kritischer Geschäftsprozesse und IT-Systeme

Zunächst müssen die Ziele und der Umfang des DRP klar definiert werden. Dazu gehört die Identifizierung kritischer Geschäftsprozesse, der zugehörigen IT-Systeme, Anwendungen und Daten, die geschützt werden müssen.

☐ Kritische Geschäftsprozesse identifizieren

☐ Abhängige IT-Systeme und Anwendungen auflisten

☐ Datenkategorien nach Kritikalität klassifizieren

☐ Geografischen Geltungsbereich definieren

📈 Risikoanalyse und BIA

Bewertung potenzieller Bedrohungen und finanzieller Auswirkungen

Eine Risikoanalyse und Geschäftsauswirkungsanalyse (BIA) sind unerlässlich, um potenzielle Bedrohungen zu bewerten und die finanziellen und operativen Folgen von Ausfällen zu quantifizieren.

☐ Bedrohungsanalyse durchführen (Naturkatastrophen, Cyberangriffe, Hardwareausfälle)

☐ Eintrittswahrscheinlichkeiten schätzen

☐ Potenzielle Schadenssummen quantifizieren

☐ Regulatorische Anforderungen berücksichtigen (DSGVO, etc.)

✅ Phase 2: Technische Anforderungen

❗ RTO und RPO festlegen

Definition von Wiederherstellungszielen für jedes kritische System

Basierend auf der BIA müssen die Recovery Time Objectives (RTOs) und Recovery Point Objectives (RPOs) für jedes kritische System und jeden Datensatz festgelegt werden. Diese Metriken bilden die Grundlage für die Auswahl geeigneter Wiederherstellungsstrategien und -technologien.

☐ RTO festlegen für jedes kritische System

☐ RPO bestimmen für verschiedene Datenkategorien

☐ Prioritäten bei limitierten Ressourcen setzen

☐ Kosten-Nutzen-Analyse durchführen

⚙️ Backup-Strategien entwickeln

Backup-Methoden, Speicherorte, erforderliche Infrastruktur